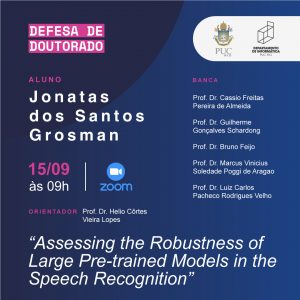

Defesa de Tese de Doutorado do aluno Jonatas do Santos Grosman

Defesa de Tese de Doutorado do aluno Jonatas do Santos Grosman

Título da tese: Assessing the Robustness of Large Pre-trained Models in the Speech Recognition

Resumo:

Utilizar representações fornecidas por um grande modelo pré-treinado tornou-se a principal estratégia para alcançar o estado da arte nas mais variadas tarefas. Um grande modelo pré-treinado recentemente proposto, wav2vec 2.0, foi seminal para vários outros trabalhos sobre pré-treinamento de grandes modelos em dados de fala. Muitos modelos estão sendo pré-treinados usando a mesma arquitetura baseada em transformer que o wav2vec 2.0 e estão obtendo o estado da arte em várias tarefas relacionadas à fala. No entanto, poucos trabalhos propuseram maiores investigações sobre a robustez desses modelos. Nosso trabalho visa investigar a robustez desses modelos em dois aspectos diferentes. O primeiro é sobre a transferibilidade entre línguas desses modelos. Nossos experimentos nos mostraram que o tamanho dos dados usados durante o pré-treinamento desses modelos não é tão crucial para a transferibilidade quanto a diversidade. Percebemos que o desempenho das línguas indo-europeias é superior ao das línguas não indo-europeias nos modelos avaliados. Vimos uma transferência positiva de conhecimento entre línguas usando modelos monolinguais, o que foi percebido em todos os idiomas que usamos, mas foi mais evidente quando o idioma usado durante o pré-treinamento era mais semelhante ao idioma do fine-tuning. O segundo aspecto de robustez que investigamos em nosso trabalho é quão bem esses modelos se comportam em cenários de desbalanceamento de dados, onde há um subconjunto mais representativo no conjunto de dados do fine-tuning. Nossos resultados mostraram que o desbalanceamento dos dados no fine-tuning geralmente afeta o resultado final dos modelos, com melhor desempenho nos subconjuntos mais representativos. No entanto, uma maior variabilidade no conjunto de treinamento favorece o desempenho do modelo para um subconjunto mais representativo. Porém essa maior variabilidade nos dados não favoreceu os idiomas não vistos durante o treinamento. Observamos também que em alguns cenários os modelos parecem mais robustos em lidar com o desbalanceamento de gênero do que idade ou sotaque. Com esses achados, esperamos ajudar a comunidade científica na utilização de modelos pré-treinados existentes, bem como auxiliar no pré-treinamento de novos modelos.

Orientador: Prof. Dr. Hélio Côrtes Vieira Lopes

Banca:

Prof. Dr. Cassio Freitas Pereira de Almeida

Prof. Dr. Guilherme Gonçalves Schardong

Prof. Dr. Bruno Feijo

Prof. Dr. Marcus Vinicius Soledade Poggi de Aragao

Prof. Dr. Luiz Carlos Pacheco Rodrigues Velho

Acompanhe-nos também no site: http://www.inf.puc-rio.br/blog/noticia/noticia/defesa-de-tese-de-doutorado-assessing-the-robustness-of-large-pre-trained-models-in-the-speech-recognition